近日,公司太阳成集团tyc539王永振博士在图像复原领域取得一系列重要研究进展,其创新性成果相继在《IEEE Transactions on Image Processing》(CCF A类,中科院一区TOP,IF:13.7)、《IEEE Transactions on Circuits and Systems for Video Technology》(CCF B类,中科院一区TOP,IF:11.1)、《IEEE Transactions on Multimedia》(CCF B类,中科院一区TOP,IF:9.7)、《Neural Networks》(CCF B类,中科院二区TOP,IF:6.3)及《计算机辅助设计与图形学学报》(中文CCF A类,EI)等国内外顶级权威期刊上发表,累计达五篇。公司均为论文第一完成单位,研究成果得到了安徽省教育厅自然科学研究重点项目、国家自然科学基金、安徽省中青年学术带头人培养计划项目及公司引进人才科研启动经费等项目的支持。

图像复原是计算机视觉的基础与关键技术,旨在从退化图像中重建高质量清晰内容,对于提升自动驾驶、遥感观测、医疗影像分析等诸多关键应用的性能具有不可替代的价值。王永振博士的系列研究,从模型架构创新、生成范式探索到实时应用落地等多个维度进行了深入探索与系统性革新。系列核心研究成果概览如下:

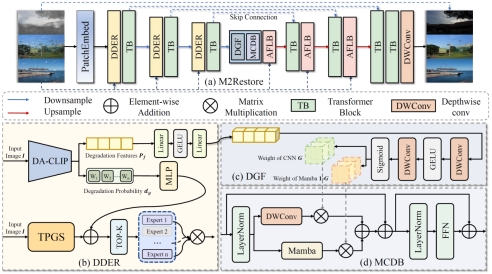

1.构建通用新框架,实现“一体化”图像恢复。作为该系列的旗舰成果,题为《M2Restore: Mixture-of-Experts-based Mamba-CNN Fusion Framework for All-in-One Image Restoration》的论文发表于图像处理领域顶级期刊《IEEE Transactions on Image Processing》。王永振博士为第一作者,其指导的本科生李勇俊为第二作者,此项成果实现了公司首次作为第一单位在该顶级期刊发表论文。此项研究致力于解决现有图像复原模型的两大核心瓶颈:一是面对噪声、模糊、雨、雾等复杂多变的混合退化场景时泛化能力不足;二是难以在保持局部精细纹理与建模全局语义依赖之间取得平衡。为此,团队提出一种全新的M2Restore框架。其核心创新在于构建了一个动态智能的“混合专家”系统,通过引入预训练的CLIP视觉语义先验,并结合可学习的任务提示,使模型能够自主识别图像中不同的退化类型与区域,从而动态调度最合适的专家网络进行处理,实现了单一模型对多种未知或复合退化的自适应精准复原。

此外,针对全局建模与局部细节的平衡难题,研究团队没有采用常规的模块堆叠方式,而是提出了Mamba-CNN双分支协同架构。该架构让擅长全局依赖建模的Mamba与专注局部特征提取的CNN并行工作,并通过一个边缘感知的动态融合门控机制,自适应地融合两者优势,即在平滑区域采用Mamba模块进行全局一致性修复,而在纹理边缘区域则利用CNN强化细节信息。这种设计使模型在应对大范围退化时能够保持整体协调,在修复细节时又能更加精准。实验结果表明,M2Restore在多种复杂退化场景下均取得了领先的复原性能,其提出的动态专家路由与全局-局部协同机制,为后续通用视觉复原模型的发展提供了重要思路。

(M2Restore网络框架图)

论文链接:https://ieeexplore.ieee.org/document/11284756

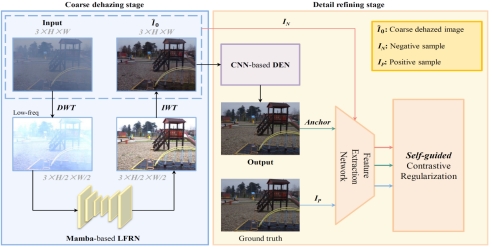

2.利用Vision Mamba架构赋能图像去雾。论文《WDMamba: When Wavelet Degradation Prior Meets Vision Mamba for Image Dehazing》发表于视频技术与电路系统领域顶级期刊《IEEE Transactions on Circuits and Systems for Video Technology》。该研究由王永振博士作为通讯作者指导硕士研究生孙杰(第一作者)完成,是公司将新兴的Vision Mamba架构成功应用于图像去雾领域的先驱性探索工作。该研究的核心始于一个重要发现:通过对雾霾图像进行小波变换分析,团队首次明确揭示了雾霾退化信息主要集中分布于图像的低频分量中。基于这一物理先验,该研究突破了传统端到端的去雾范式,提出了“先恢复全局结构,再增强局部细节”的粗-精两阶段解耦框架。在第一阶段,团队设计了一种基于Vision Mamba的低频恢复网络。Mamba模块凭借其线性复杂度的全局建模能力,专门负责消除弥漫性的雾霾,恢复图像的整体对比度与基础结构,得到一张粗略去雾结果。在第二阶段,团队精心设计了一个CNN细节增强网络,专注于从频域和空间域中挖掘并修复在第一阶段可能丢失的高频纹理与边缘信息。

为了进一步提升模型复原效果的自然度与真实性,该研究还提出了一个巧妙的“自引导对比正则化”策略。该策略将第一阶段产生的粗略去雾结果作为一种“有难度的负样本”,迫使网络最终的输出在特征空间中远离这个仍有缺陷的中间结果,从而更精准地向清晰无雾的图像靠近。这些设计使得WDMamba不仅在合成与真实雾霾数据集上取得了领先的定量结果,更在视觉上实现了细节保留与色彩保真的优异平衡,为复杂场景下的高效图像去雾提供了新颖且有效的解决方案。

(WDMamba整体框架图)

论文链接:https://ieeexplore.ieee.org/document/11180084

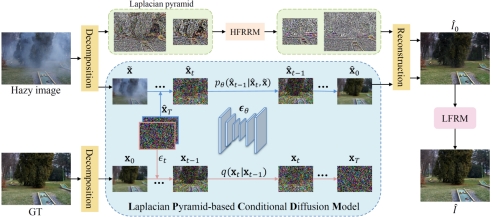

3.探索生成新范式,扩散模型实现高保真实景去雾。在论文《Real-Scene Image Dehazing via Laplacian Pyramid-based Conditional Diffusion Model》中,深入探索了扩散模型在真实复杂雾天场景下的应用。该文发表于多媒体领域顶级期刊《IEEE Transactions on Multimedia》,王永振博士为论文第一作者,刘恒教授为通讯作者。该研究针对真实场景中复杂、非均匀的雾霾分布,传统去雾方法常因训练数据有限、域差异大而表现不佳。为此,探索了一种基于生成式扩散模型图像去雾方法。具体来说,这里提出一种拉普拉斯金字塔条件扩散模型用于真实场景图像去雾,并通过多尺度分解与精细化生成机制,在彻底去除雾霾的同时,尽可能保留图像的结构细节与色彩真实感。该模型是首次将拉普拉斯金字塔与条件扩散相结合,将输入图像分解为低频结构信息与高频细节残差,分别在低分辨率空间进行扩散去雾和高频重建,大幅提升了推理效率并避免了信息损失。此外,通过引入低频细化模块,进一步挖掘训练数据中的深层信息,增强了模型在真实雾霾场景下的复原性能。

该方法在多个真实场景数据集(如NH-HAZE、Dense-HAZE等)上进行了系统验证,在PSNR、SSIM等客观指标与视觉质量上均明显优于现有主流方法。实验结果表明,该研究在保持高保真复原效果的同时,推理速度较传统扩散模型提升约150倍,为实现高效、高质的真实场景图像去雾提供了可行的生成式复原新思路。

(去雾网络整体结构图)

论文链接:https://ieeexplore.ieee.org/document/11249427

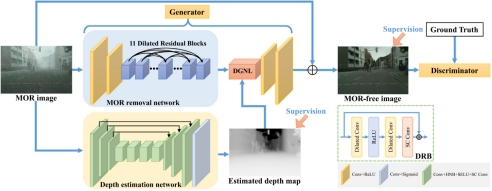

4.攻坚特定难题,深度引导混合雨雾去除新方法。针对真实场景中多种雨水(雨滴、雨线、雨雾)混合叠加这一特定难题,论文《Rethinking Mixture of Rain Removal via Depth-Guided Adversarial Learning》提出了一种基于深度引导的对抗学习框架,该论文发表于神经网络领域权威期刊《Neural Networks》,王永振博士为论文第一作者。该研究通过引入场景的深度信息作为一种额外的先验知识,将深度估计任务与混合雨雾去除任务相结合,构建了一种名为DEMore-Net的联合学习网络。该网络充分利用了雨水分布与场景深度的联系,通过深度信息指导网络在根部不同距离对不同类型的雨水进行精准去除,有效提升了模型在复杂雨雾场景下的泛化能力与复原精度。

在方法设计上,DEMore-Net构建了基于编码器-解码器的深度估计子网络和基于生成对抗网络的雨雾去除子网络,并引入深度引导的非局部模块实现特征融合,使复原过程更符合真实物理退化过程。此外,论文还创新性地提出一种混合归一化模块,该模块结合了批归一化与实例归一化各自的优势,显著增强了网络训练的稳定性与学习能力。实验结果表明,该方法在合成数据集RainCityscapes++和真实雨天场景下均显著优于现有最先进的图像去雨算法,在PSNR、SSIM等客观指标及视觉质量上均达到最优,为复杂天气下的图像复原提供了有效的深度引导新范式。

(去雨网络整体结构图)

论文链接:https://www.sciencedirect.com/science/article/pii/S0893608025006197

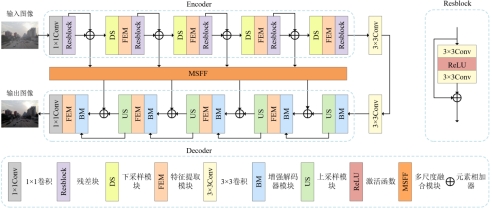

5.聚焦落地应用,研发轻量化实时图像去雾算法。针对自动驾驶、视频监控等实际应用场景对图像处理实时性的迫切需求,论文《一种融合多尺度与局部特征增强的实时图像去雾算法》致力于开发一种兼顾效率与性能的轻量化去雾模型。该论文发表于中国计算机学会(CCF)推荐的A类中文期刊《计算机辅助设计与图形学学报》,王永振博士为论文第一作者,刘恒教授为通讯作者。该研究设计了一种全新的轻量级特征提取模块,通过采用通道切分策略,在减少模型计算量的同时有效提取到图像的局部特征。此外,通过所构建的多尺度特征融合模块与增强解码模块,实现了多尺度上下文信息互补与雾区自适应增强,在保证复原精度的同时大幅提升模型推理速度。

实验结果表明,该算法在合成数据集SOTS上取得PSNR/SSIM 32.32 dB/0.979(室内)与33.39 dB/0.982(室外)的优异表现,在真实场景数据集RTTS上亦表现鲁棒。更为重要的是,其单幅图像的平均处理时间仅需0.0261秒,在参数量与计算复杂度显著低于主流方法的同时,实现了实时去雾处理,为高动态视觉系统中的实时图像增强提供了高效可行的轻量化解决方案。

(网络整体结构图)

论文链接:https://www.jcad.cn/article/doi/10.3724/SP.J.1089.2024-00497

上述研究工作聚焦图像去雾、去雨及一体化复原等核心任务,开创性地引入了混合专家系统、Vision Mamba、条件扩散模型等前沿架构,提出了多种高性能算法,彰显了公司在计算机视觉前沿领域的国际一流研究水平与持续创新能力。

(撰稿:王永振 审核:黄俊 夏玉钦)